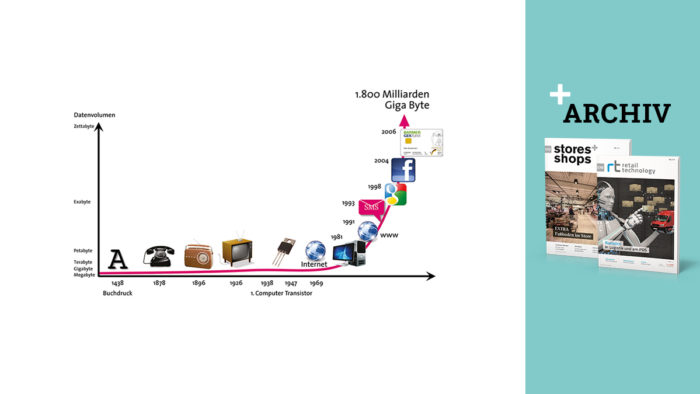

Big Data bedeutet: Riesige, bei Handelsunternehmen häufig bereits in Data Warehouse Systemen vorhandene Datenmengen werden neu geordnet, strukturiert, miteinander vernetzt und laufend durch zusätzliche aktuelle Informationen ergänzt. So bilden sie die Grundlage für Trenderkennungen und Prognosen. In kürzester Zeit entstehen, etwa bei einem Online-Händler, auf diese Weise zig Millionen neue Datensätze. Erst die Verfügbarkeit leistungsfähiger, billiger Speichertechnologien ermöglicht es, mit solchen Informationsmengen sinnvoll zu arbeiten.

Bei seinem Einkaufsbummel durchs Netz hinterlässt der Kunde eine Menge Spuren: was schaut er sich an, bei welchen Artikeln verweilt er wie lange, was wählt er aus, was kauft er schließlich, welche Preislagen, welche Farben bevorzugt er, wählt er eher modisch oder eher konservativ, welche sportlichen und kulturellen Interessen lässt er erkennen, will er „fair“ handeln, wie hält er es mit ökologischen Prinzipien – die Reihe lässt sich fortsetzen. Für jedes dieser Merkmale kann eine elektronische Notiz, ein Cookie, im Computer des Seitenbesuchers gesetzt werden. Das ist eine Textinformation, die bei späteren Besuchen dieser Seite immer wieder an den Server des Seitenbetreibers zurückgesendet würde.

So entsteht nach und nach ein immer genaueres Bild des Kunden, das bei Big-Data-Analysen durch Bild- und Audiodateien aus den sozialen Netzwerken ergänzt werden kann. Die Prognosesoftware erkennt aus diesem „Datensammelsurium“ Zusammenhänge und Muster. Es können zusätzliche Daten aus Googleklicks u.a. herangezogen werden. Das mathematische Verfahren für die komplizierten Berechnungen haben die Softwareentwickler aus der experimentellen Elementarteilchenphysik abgeleitet.

Otto generiert Vorhersagen

In ihrem klassischen Versandhandelsbereich arbeitet die Otto-Gruppe seit 6 Jahren mit wissenschaftlichen Prognosesystemen. Alexander Pompös ist Projektleiter für dieses Fachgebiet. Inzwischen arbeitet er mit der Software von Blue Yonder aus Karlsruhe. Die Datenhaltung und -aufbereitung geschieht u.a. in Data-Warehouse-Systemen von Teradata. Teradata und Blue Yonder arbeiten eng zusammen.

„Als Versender mit einem Sortiment von über zwei Millionen Artikeln brauchen wir zuverlässige Absatzprognosen, um gut disponieren zu können und keine Überhänge einzukaufen“, erläutert Alexander Pompös. „Heute können wir durch das Zusammenspiel aktueller und historischer Daten nicht nur Zusammenhänge erkennen, sondern daraus Vorhersagen generieren.“ Otto sammelt alle Bewegungs- und Stammdaten über Sortimente, Kunden und Absatz schon seit Jahren. Pompös hält diesen inzwischen unvorstellbar großen Datenbestand für eine unverzichtbare Voraussetzung für Prognoseberechnungen.

Für die Planung neuer Kollektionen müssen die voraussichtlichen Abverkäufe und Ordermengen möglichst präzise eingeschätzt werden. Früher berechneten die Disponenten jeden Katalogartikel praktisch „in Handarbeit“. Heute nutzt Otto Blue Yonder als Dienstleister. Alexander Pompös: „Dabei ziehen wir nicht mehr alle Artikel heran, sondern konzentrieren uns auf die mit dem stärksten Durchsatz.“ Die Vorschläge basieren auf allen verfügbaren aktuellen Einflussfaktoren und berücksichtigen den Verlauf eines vergleichbaren Artikels in der Vergangenheit. Dieses Verfahren läuft weitgehend automatisiert ab und erzielt laut Otto Group Prognoseverbesserungen von bis zu 40 Prozent.

Wetterdaten zweifelhaft

Auch Wetterdaten fließen in die Berechnungen ein. Inwieweit diese allerdings zur Verbesserung der Prognose beitragen, soll dahingestellt bleiben. Langfristige verlässliche Wettervorhersagen gibt es einfach nicht, und der Wetterverlauf und seine Auswirkungen auf den Einzelhandel im ersten Halbjahr 2013 haben wieder einmal gezeigt, was von Erfahrungswerten auf diesem Gebiet zu halten ist.

An eher gesicherten Fakten orientiert sich dafür die automatische Preisfindung, die tagesaktuell für 300.000 Artikel den „idealen Preis“ ermittelt. Dazu werden systematisch Markterkenntnisse aus Preistests herangezogen. Das System zieht Schlüsse, was die Kunden bereit sind zu bezahlen, erstellt Preis- und Mengenschätzungen auf Grundlage der optimalen Preise, steuert die Preisgestaltung und überwacht alle Pricing-Prozesse.

Mit Retouren lebt der Versandhandel seit eh und je. Retouren sind für die Kunden ein toller Service, aber sie kosten den Händler viel Geld, und wohl deshalb wird sich selbst Zalando entschlossen haben, damit nicht mehr zu werben. Man wird Retouren nie ausschließen können, auch deshalb ist der Gedanke von Amazon, besonders „retourenaktive Kunden“ auszulisten, zumindest unternehmerisch zweifelhaft, schließlich gehören sie zum Prinzip des Versandhandels. Bei Otto helfen die „Predictive Analytics“ (Blue Yonder) jetzt schon seit zwei Jahren, die Retourenquote „ergebnisverträglicher“ zu gestalten.

„Hier mussten wir erst einmal die vielen Einflussgrößen auf die Retouren bestimmen und analysieren“, so Alexander Pompös. „Warum kommen sie zustande, welche sind auf Auswahlen zurückzuführen, welchen Einfluss hat die Artikeldarstellung im Internet oder im Katalog? Wir haben dazu zehn Themengebiete identifiziert und alle Datenquellen dazu an Blue Yonder übergeben, um unsere Arbeitshypothesen überprüfen zu lassen.“ Für die drei erfolgversprechendsten Einflussfaktoren wurden dann Maßnahmen zur Retourensenkung entwickelt. So gibt es vorsichtige Appelle an das Umweltbewusstsein. Oder Kunden, die einen Artikel in zwei Größen bestellen, werden auf „die gute Passform“ noch einmal hingewiesen, viele davon ziehen dann die Zweitbestellung zurück. Die Anzahl der Retouren ist, heißt es bei Otto, deutlich zurückgegangen.

Solche Ergebnisse, ob im Bereich der Retouren, bei Absatzprognosen oder Trendbestimmungen, bestätigen oft die „Vermutungen“, die sich im Vorfeld zu diesen Fragestellungen gebildet hatten. Alexander Pompös nennt das „die Quantifizierung des Bauchgefühls“.

Stationär als „Zubringer“

SportScheck gehört seit 1991 zur Otto-Gruppe. 80 Prozent des Versandhandelsumsatzes kommen online zustande. Guido Jaenisch ist Geschäftsführer des Unternehmens und sieht das stationäre Geschäft als „Zubringer“ für den Onlinehandel: „Skianzüge für 1.500 Euro kaufen Kunden weiterhin bevorzugt stationär. Deshalb wird der Store in diesem Genre dem Netz auch in Zukunft überlegen sein. Dennoch sind wir auf dem Weg zu einer Internet-getriebenen Company.“ So werden im Onlineshop gesammelte Daten daraufhin untersucht, warum ein Kunde einen eingeleiteten Kaufvorgang wieder abbricht. „Mit 6,5 Prozent haben wir eine vergleichsweise gute Kaufquote“, so Jaenisch, „aber 93,5 Prozent der Interessenten verlassen unsere Seite ohne Kaufabschluss. Wenn wir hier nur um einen Prozentpunkt besser werden, bringt uns das einen großen Schritt nach vorn.“

Selbstlernende Software soll bald den Kunden beim Onlineshopping begleiten und Vorschläge machen, sobald er zögert oder einen Artikel aus dem Warenkorb wieder zurücklegt. Die Echtzeitreaktion soll dem Kunden signalisieren, hier geht man auf meine Wünsche ein, hier kümmert man sich um mich. So soll sich das Online-Einkaufserlebnis der stationären Einkaufserfahrung annähern.

Absatzprognosen entstanden bei SportScheck in der Vergangenheit hauptsächlich durch Pretests auf der Basis des Kataloggeschäfts. „Wir setzen heute auf Internettechnologien“, so Jaenisch. Im Filialgeschäft kann SportScheck nach eigener Aussage innerhalb von 36 Stunden die Warennachversorgung garantieren. Im Versandgeschäft verhilft die moderne Prognosesoftware zu schnellerer Disposition und verkürzt die Lieferzeiten zum Kunden durch bessere Warenverfügbarkeit. Der Online-Handel lebt von kurzen Zyklen und hohen Stückzahlen. „Wir verschicken täglich bis zu 40.000 Pakete an unsere Kunden“, berichtet Jaenisch. Insgesamt entstehen Tag für Tag 25 Mio. Informationssätze. Die werden für die Sortimentsprognosen bis hinunter zum Einzelartikel benötigt.

„Um solche Informationsmengen überhaupt bearbeiten zu können haben wir Verfahren zur automatischen Strukturierung entwickelt“, erklärt Uwe Weiss, CEO von Blue Yonder. „Nur der strukturelle Aufbau der Daten kann die Vergleichbarkeit von Informationen gewährleisten, ohne die Prognosen nicht möglich sind. In Sortimentsteilen erreicht das System bei SportScheck bereits Verbesserungen von 30 Prozent, so das Unternehmen. Und, ähnlich wie bei Otto, konnte die Retourenquote eingedämmt werden.

„Inzwischen setzen wir diese Techniken für das gesamte Sortiment ein“, sagt Guido Jaenisch. Ausgehend von einer Gesamtbetrachtung nehmen sich die Disponenten dann gezielt die Warengruppen oder auch Einzelartikel vor, bei denen das höchste Optimierungspotenzial liegt. Immer gilt: Je größer die historische Datenbasis, desto besser sind die Erfolgsaussichten für die Prognose. Also: Nichts wegschmeißen.

Foto: Fotolia / buchachon

„Die Herausforderung liegt in der Datenstruktur“

Martin Willcox, Director Product and Solutions Marketing International bei Teradata, erläutert, welche zwei zentralen Herausforderungen es zu meistern gilt:

Dass Daten wertvolle Ressourcen sind, ist kein Geheimnis. Kundendaten aus Bonusprogrammen oder Onlineshops eröffnen Einzelhändlern ungeahnte Möglichkeiten. Doch wie kann das Rohmaterial bestmöglich genutzt werden? Es gilt, zwei Herausforderungen zu meistern: die riesigen Datenmengen, die durch neue Technologien und den Trend zum Online-Shopping ständig ansteigen, sowie die wachsende Vielfalt der Datenstrukturen. Daten bestehen nicht mehr nur aus strukturierten Zahlen und Fakten wie dem Geburtsdatum eines Kunden oder seinen monatlichen Ausgaben. Sogenannte Big Data beinhalten Informationen, die sich in Bildern, Audiodateien, sozialen Netzwerken oder Online-Rezensionen verbergen.

Die Kombination aus strukturierten und multistrukturierten Daten gibt eine Rundum-Sicht auf Kundenbeziehungen und liefert dem Einzelhändler so wertvolle Informationen. Deshalb beinhaltet eine analytische Infrastruktur wie die „Teradata Unified Data Architecture“ Technologien sowohl für Big Data als auch für traditionelle Daten. So können multistrukturierte Daten in einem Framework wie Hadoop mit strukturierten Daten in einer relationalen Datenbank in einen gemeinsamen Analysezusammenhang gebracht werden. Unabhängig von Datenmenge und -struktur ermöglicht ein solch integriertes Umfeld jede Datenanalyse und -kombination. Indem die Nutzer ihre gewohnten BI-Tools und Schnittstellen nutzen können, sind Big Data-Analysen auch für Geschäftsanwender außerhalb der IT zugänglich.